Что такое Aardvark?

OpenAI представила Aardvark — автономного «агента-исследователя по безопасности», работающего на модели GPT-5. Этот инструмент интегрируется в процессы разработки, постоянно анализирует кодовые базы, выявляет потенциальные уязвимости, оценивает возможность эксплуатации и предлагает точечные исправления.

Главное отличие Aardvark — он анализирует код как человек-исследователь, используя логические рассуждения, а не только традиционные сканеры, фреймворки и сигнатуры.

- Агент работает в режиме закрытой беты и способен подключаться к GitHub и другим CI/CD-системам.

- GPT-5, на котором основан Aardvark, использует новую архитектуру «router model» — она автоматически выбирает оптимальную под-модель под конкретную задачу.

- Модель поддерживает мультимодальность и расширенное контекстное рассуждение, что позволяет ей понимать сложные цепочки уязвимостей, включая логические ошибки.

Почему это важно для команд разработки и безопасности

Число уязвимостей растёт каждый год, кодовые базы разрастаются, а скорость разработки увеличивается. Aardvark меняет подход от периодических проверок к непрерывной автоматизированной защите.

Исследовательские данные:

| Метрика | Значение |

|---|---|

| Доля найденных известных уязвимостей в тестовых репозиториях | ~92% |

| Тип анализа | не только сигнатуры, но и причинно-следственная логика |

| Формат результата | объяснение, проверка, предложение исправления |

В отличие от SAST/DAST-инструментов, Aardvark понимает контекст и намерения разработчика, что снижает шум и количество ложных срабатываний.

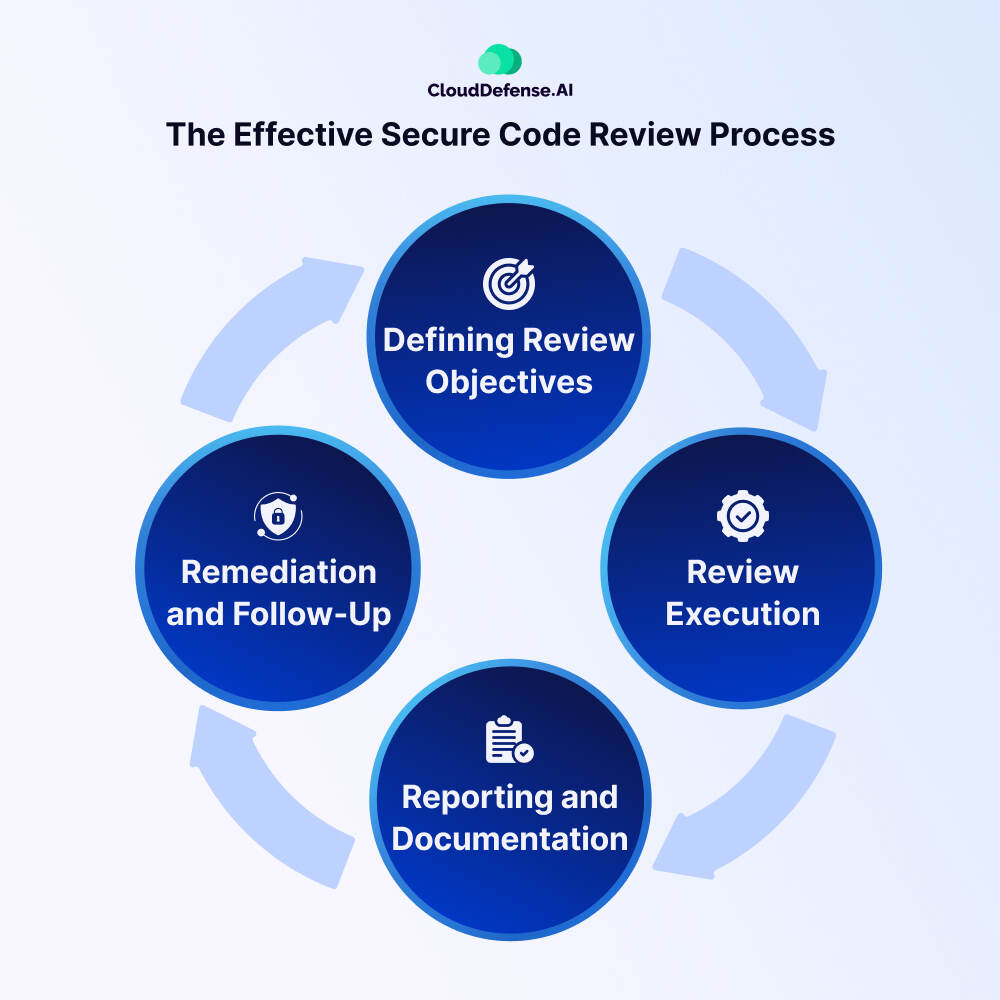

Как работает агент Aardvark (упрощённо)

- Построение модели угроз: анализирует архитектуру и расположение критичных компонентов.

- Мониторинг изменений кода: отслеживает коммиты и pull-requests.

- Выявление уязвимостей: ищет логические ошибки, небезопасные функции, неправильные зависимости.

- Валидация уязвимости в песочнице: проверяет, может ли ошибка быть реально использована.

- Формирование исправлений: предлагает патчи, пишет pull-request и оставляет комментарии кода.

- Человек подтвердает изменения: финальное решение остаётся за разработчиками и AppSec-командой.

Контекст и комментарии экспертов

Исследования показывают, что LLM-агенты обладают новыми типами поведения:

- могут координировать использование инструментов;

- способны выполнять многошаговые задачи без прямого контроля;

- могут ошибаться нестандартным образом, если контекст интерпретирован неверно.

Публикации в arXiv отмечают, что такие агенты требуют прозрачности и аудитируемости, особенно в области безопасности.

Применение Aardvark

| Сценарий применения | Польза |

|---|---|

| Большие корпоративные кодовые базы | автоматизация рутинных ревью |

| CI/CD и DevOps | уязвимости обнаруживаются до релиза |

| Финансовые и критические системы | снижает операционные риски |

| Open-source проекты | повышает качество безопасности сообщества |

Ограничения и риски

- Агент не заменяет AppSec-специалистов, а усиливает их.

- Возможны ложные срабатывания или пропуски, особенно в сложных архитектурах.

- Важно обеспечить прозрачность решений ИИ и понятность причинно-следственных объяснений.

- Необходимо внимательно управлять доступами и средами исполнения.

Вывод

Aardvark — важный шаг в сторону постоянного, интеллектуального и автономного контроля безопасности.

Он не просто ищет ошибки, а объясняет их и помогает исправлять, приближая команду к модели «безопасность встроена по умолчанию».

Будущее безопасной разработки всё больше зависит от сотрудничества человека и ИИ, где ИИ помогает масштабировать экспертизу, а человек обеспечивает стратегические решения.