AI-ассистенты для разработки кода перестали быть игрушкой: в 2024–2025 годах они стали частью повседневной работы программистов. Современные модели не только пишут функции по подсказке — они учитывают содержимое репозитория, предлагают исправления, генерируют тесты и помогают в ревью. Ниже — факты, компактное сравнение и прогнозы по развитию LLM на будущее.

Коротко — что умеют кодовые LLM

- Генерация и автодополнение: от единичных функций до шаблонов файлов.

- Контекст-чувствительные подсказки: учитывают код в репозитории, тесты, docstring’и.

- Отладка и объяснение ошибок: предлагают исправления, описывают причины неудачных тестов.

- Агентные сценарии: могут запускать тесты, исправлять и повторять цепочку действий (agentic workflows).

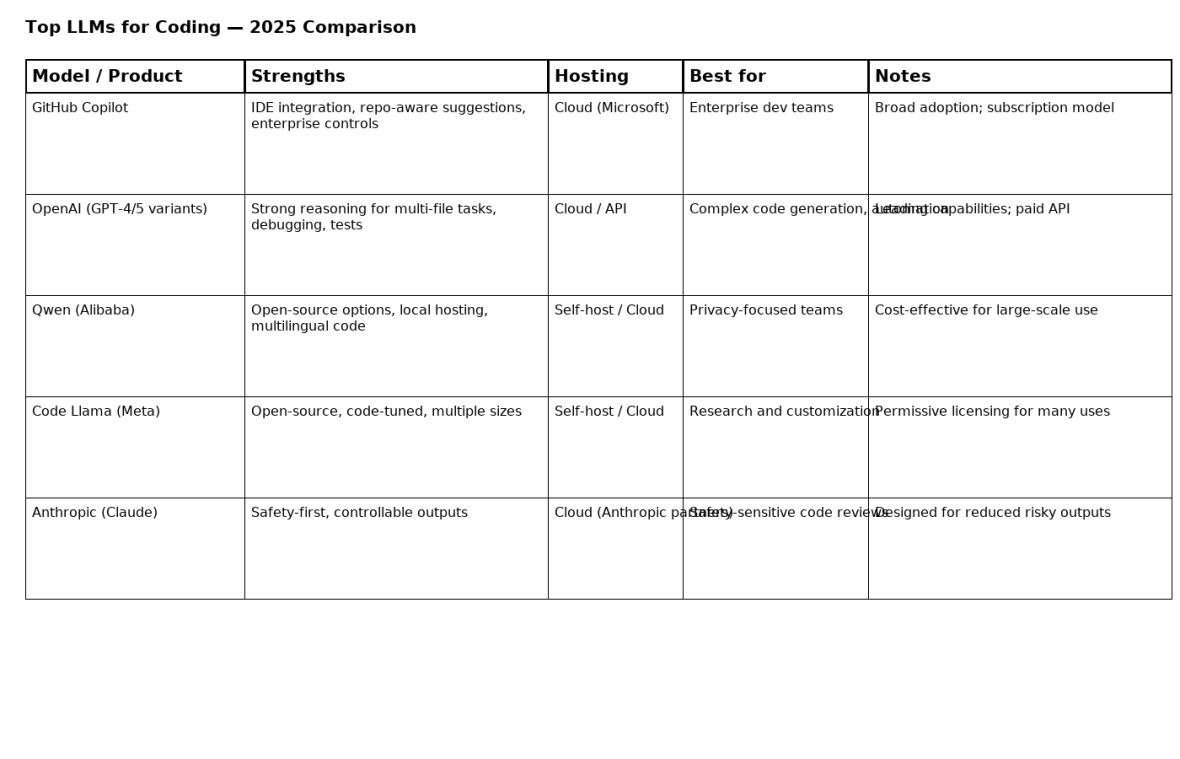

Короткий обзор ведущих игроков (2025)

GitHub Copilot — «рабочая лошадка» для команд

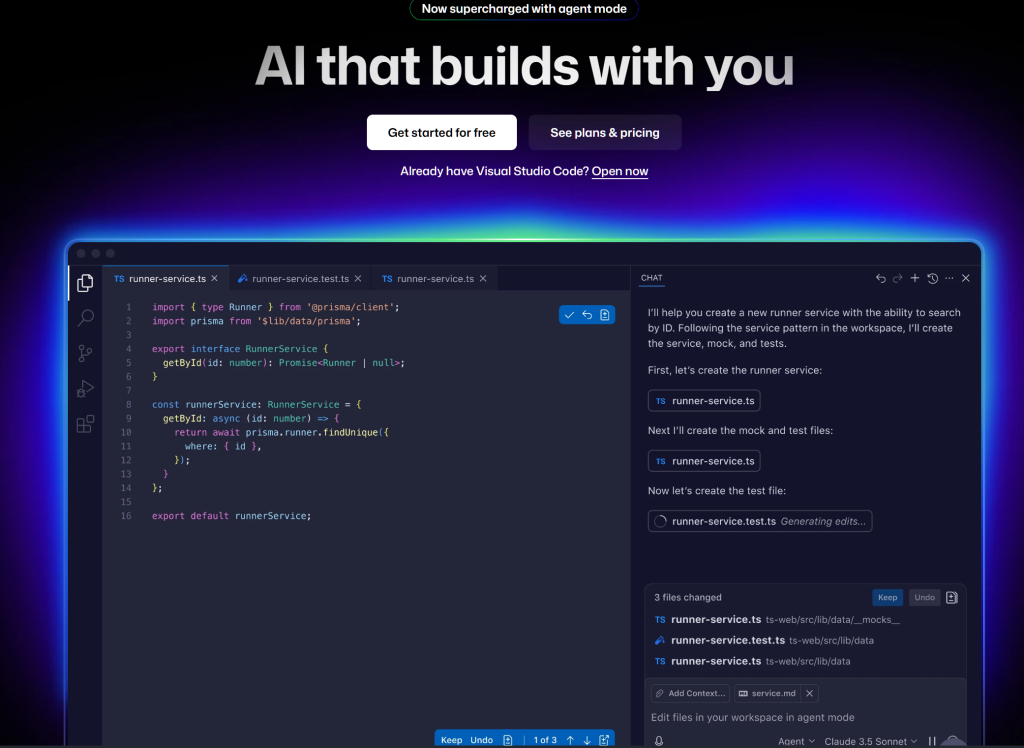

Copilot прочно интегрирован в IDE (VS Code, JetBrains и др.), поддерживает настройки для бизнеса и управление данными. По отчетам Microsoft/ GitHub, Copilot превысил 20 млн зарегистрированных пользователей и используется в ~90% компаний из Fortune 100 — это делает его естественным выбором для корпоративных команд.

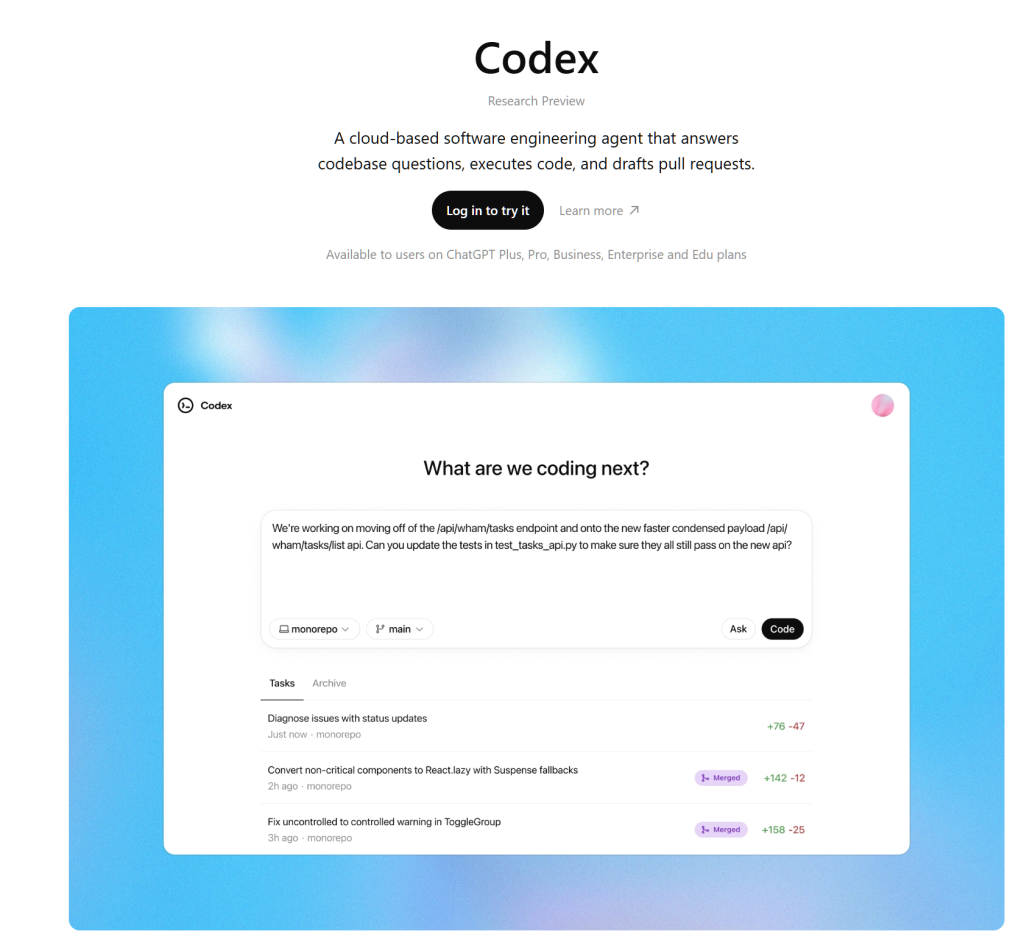

OpenAI (GPT-семейство, кодовые варианты)

OpenAI Codex основной сильной стороной является генерация сложных многомодульных решений, рефакторинг и агентные сценария. Модельные улучшения дают сильную контекстную и логическую составляющую, полезную при больших задачах по архитектуре и отладке. (Коммерческие API-решения остаются облачными и платными.)

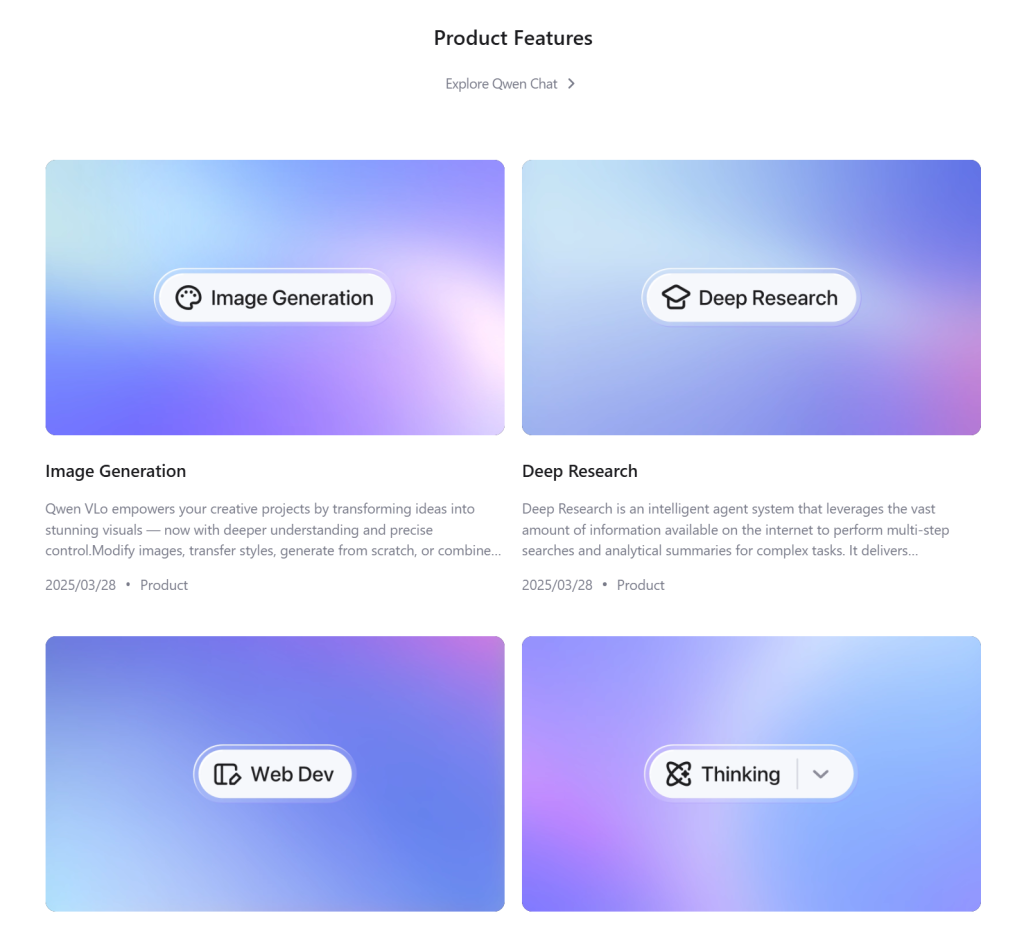

Qwen / Qwen3-Coder (Alibaba) — локальный и масштабируемый

Alibaba активно развивает линейку Qwen, включая «Qwen3-Coder» — агентную модель, рассчитанную на большие контексты и предназначенную для корпоративного использования и локального развёртывания, что даёт возможность работать с закрытыми репозиториями без передачи данных в публичное облако.

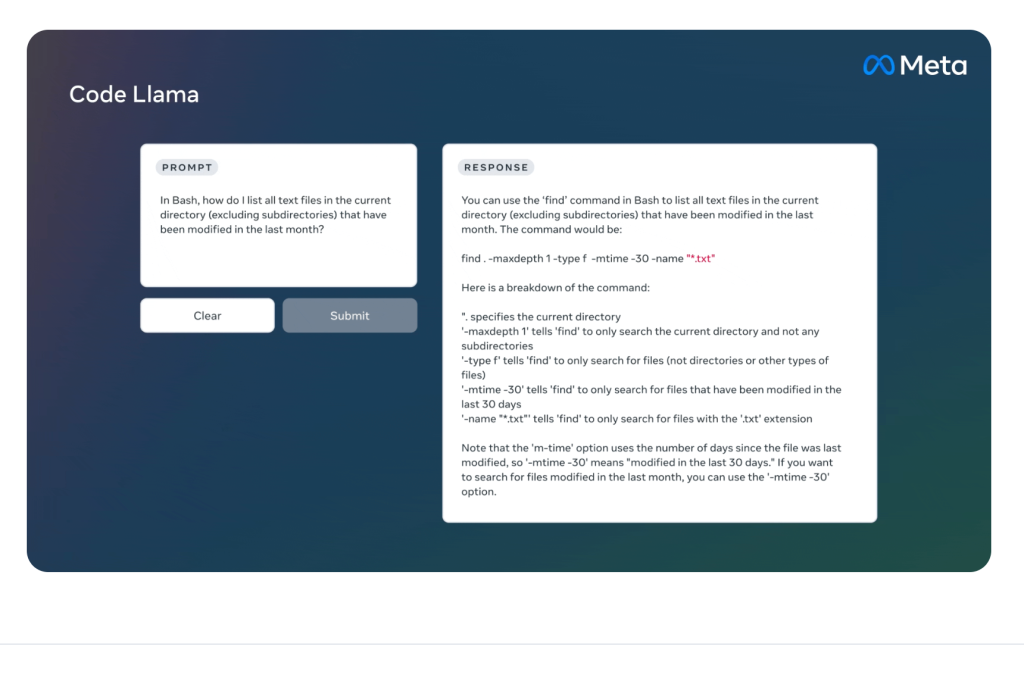

Code Llama (Meta) — открытый и настраиваемый

Code Llama (и более широкая линейка Llama) — это open-source-подход, позволяющий запускать модели локально, дообучать под свои данные и интегрировать в собственные пайплайны. Meta активно развивает Llama и увеличивает возможности по контексту и мульти-модальности.

Anthropic (Claude) — безопасность и управление

Anthropic делает ставку на «безопасность по умолчанию» и контролируемость поведения модели; недавние инициативы по интеграции Claude в офисные/IDE-решения ориентированы на enterprise-задачи с повышенными требованиями к соответствию и аудитам. Партнёрства с крупными вендорами направлены на встраивание безопасных агентов в корпоративную разработку.

Краткое сравнение — что умеют LLM

- Генерация и автодополнение: от единичных функций до шаблонов файлов.

- Контекст-чувствительные подсказки: учитывают код в репозитории, тесты, docstring’и.

- Отладка и объяснение ошибок: предлагают исправления, описывают причины падений тестов.

- Агентные сценарии: могут запускать тесты, исправлять и повторять цепочку действий (agentic workflows).

Несколько интересных фактов и инсайтов

- GitHub Copilot пересёк отметку в ~20 млн пользователей и заявленную долю в 90% компаний Fortune 100, что демонстрирует корпоративную зависимость от инструментов автогенерации кода в 2025 году.

- Модели нового поколения (например, Qwen3-Coder) проектируются с огромными контекстными окнами (сотни тысяч токенов и методы экстраполяции до миллионов токенов), что меняет сценарии: теперь модель может «видеть» весь репозиторий и тест-суиты целиком.

- Open-source экосистема (Code Llama / Llama 4) двигается вперёд: Llama-семейство развивает нативную мульти-модальность и очень длинные контексты, что делает локальные развёртывания более мощными и практичными.

- Появляется тренд объединения LLM и классических SDLC-инструментов: автоматические ревью, сканирование на уязвимости и синтез патчей. Партнёрства (например, Anthropic+IBM для интеграции в IDE) ускоряют внедрение таких сценариев в больших компаниях.

Практический чеклист — как выбрать и внедрить LLM для команды

- Определите требования к данным: можно ли отправлять репозиторий в облако или нужен on-premise?

- Запустите пилот: измеряйте время разработки, количество исправленных багов, качество автогенерации (coverage тестов).

- Политика безопасности: настройте запрет на отправку секретов, используйте DLP и прокси-логирование запросов.

- CI/QA-шлюзы: любые изменения, сгенерированные моделью, должны проходить автоматические тесты и ревью человеком.

- Отслеживайте происхождение кода: фиксируйте, какой моделью сгенерирован фрагмент (важно для лицензирования и аудита).

- Шедулите апдейты и валидацию: модель устаревает — регулярно проводите оценку качества и bias/разведку на уязвимости.

Прогнозы (2025–2026)

- Агентность станет нормой. Инструменты будут не просто предлагать код, а самостоятельно собирать тесты, прогонять CI, исправлять и предлагать PR-шаблоны (человеческая проверка останется обязательной).

- Открытые модели поднимут планку локального хостинга. Llama-семейство и Qwen позволят компаниям снизить затраты и соответствовать требованиям.

- Стандарты валидации кода. Появятся «проверочные конвейеры» для AI-генерированного кода: автоматические тесты + статический анализ + проверка лицензий.

- Новые рабочие роли. Будут востребованы инженеры, которые умеют «оценивать модели»: prompt-инженеры, AI-ревьюверы, инженеры по валидации безопасности кода.

Риски — не игнорируйте их

- Генерация уязвимостей: LLM могут синтезировать небезопасный код или подтянуть устаревшие библиотеки — автоматический сканинг обязателен.

- Лицензирование: фрагменты, сгенерированные моделью, могут перекликаться с обучающим корпусом — важно вести учёт и применять сканеры лицензий.

- Переизбыточное доверие: разработчики склонны принимать первый результат — введите правило «проверил — принял».

Заключение

Мир кодовых LLM быстро шлифует сценарии продуктового использования: интеграция в IDE, расширенные контексты, агентные цепочки и массовое корпоративное принятие. На практике выиграют те команды, которые объединят удобные облачные инструменты (Copilot/OpenAI) с локальными «резервными» моделями (Qwen, Code Llama) и построят над ними надежные валидационные пайплайны и политики безопасности. сравнение (текст)

- Интеграция IDE: Copilot > OpenAI > сторонние плагины для Qwen/Code Llama.

- Возможность self-host: Qwen, Code Llama >> OpenAI/Anthropic/Copilot (облачные по умолчанию).

- Готовность для предприятия: Copilot & OpenAI лидируют (SLA, биллинг, DLP-опции).

- Безопасность: Anthropic фокусируется на guardrails; GitHub предлагает опции отказа от использования данных для обучения.

- Стоимость: открытые локальные модели снижают API-расходы, но повышают требования к инфрастуктуре.